Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

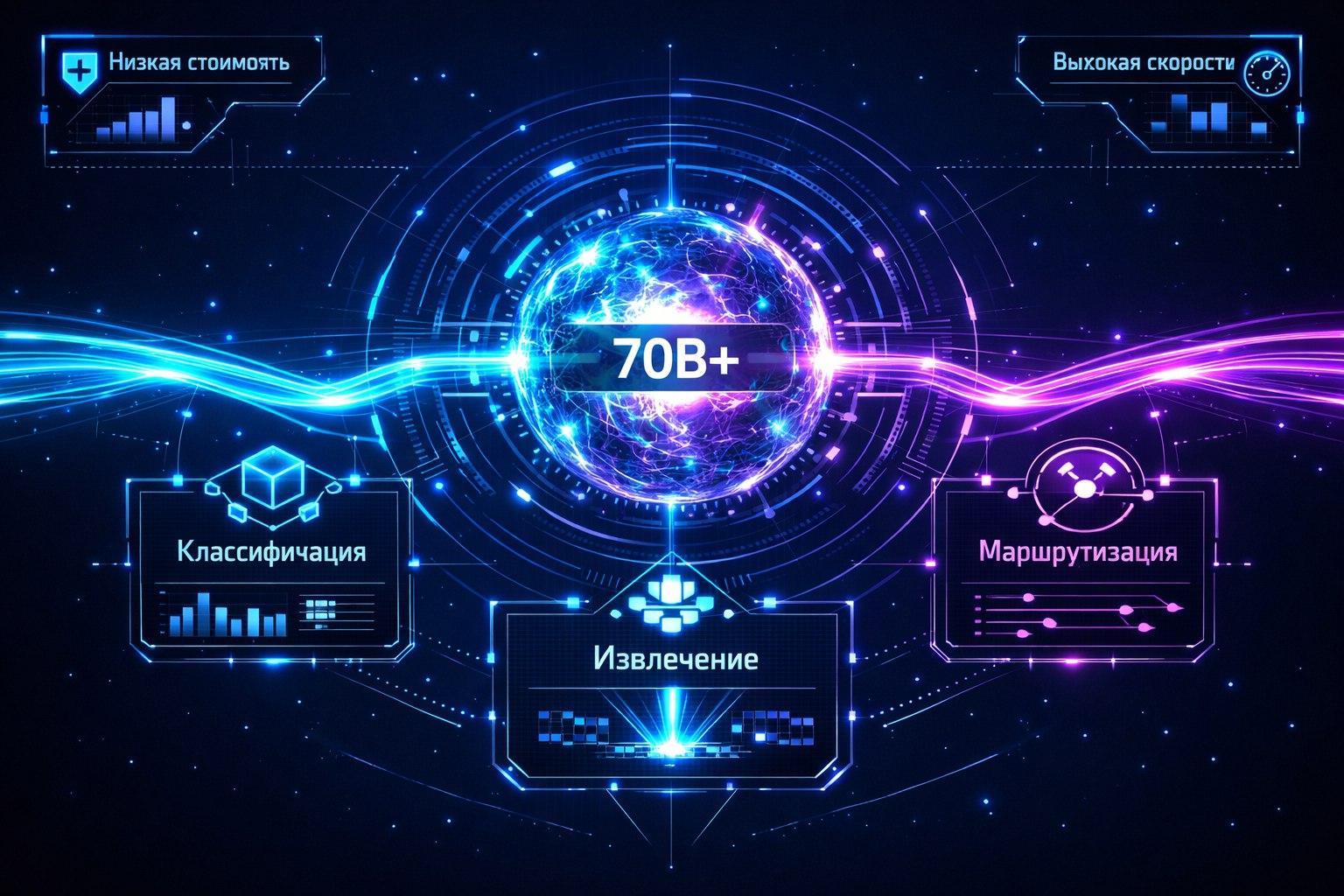

Phi-3, Gemma, TinyLlama и другие. Как выбрать и использовать компактные модели для классификации, извлечения данных и простых действий.

Вам не нужен суперкомпьютер, чтобы определить намерение в сообщении или извлечь дату из письма. Маленькие языковые модели (Small LLMs) — это специализированный инструмент, который делает одну или несколько задач быстрее, дешевле и надежнее, чем их огромные собратья. Давайте разберем их силу, слабости и идеальные сценарии использования.

Ключевые отличия маленьких моделей от больших:

| Критерий | Большая модель (70B+) | Маленькая модель (1B-7B) |

|---|---|---|

| Рассуждения (Reasoning) | Сильны в сложных, многошаговых логических выводах. | Слабые. Не способны на глубокие рассуждения. |

| Следование инструкциям | Отличное, понимают сложные, многосоставные промпты. | Ограниченное. Лучше работают с простыми, четкими инструкциями. |

| Знание мира (Knowledge) | Обширные, но общие знания. | Очень ограниченные. Без RAG почти бесполезны как энциклопедия. |

| Креативность | Высокая. | Низкая, шаблонная. |

| Стоимость инференса | Очень высокая (дорогое железо, много токенов). | Очень низкая (работает на CPU/маленькой GPU). |

| Скорость (Latency) | Высокая (секунды). | Очень низкая (миллисекунды). |

| Предсказуемость | Ниже (могут «галлюцинировать»). | Выше. Более детерминированы для узких задач. |

| Fine-tuning | Сложно и дорого. | Просто и дешево (можно на одной GPU за пару часов). |

Идеальные сценарии для маленьких моделей:

Классификация текста (Text Classification): Определение тональности, категории запроса (например, "техническая проблема", "вопрос по оплате"), спам-фильтрация.

Извлечение именованных сущностей (Named Entity Recognition - NER): Поиск в тексте дат, сумм, имен, названий компаний, продуктов.

Извлечение структурированных данных (Information Extraction): Преобразование неструктурированного текста (резюме, письмо, новость) в структурированный JSON по заданному шаблону.

Перефразирование и нормализация текста (Text Normalization): Приведение текста к единому стилю, исправление опечаток, упрощение формулировок.

Маршрутизация запросов (Intent Classification & Routing): Определение, какому сервису или большой модели передать сложный запрос пользователя.

Простые, шаблонные диалоги (Slot Filling): Сбор информации по скрипту: "Назовите вашу дату рождения? -> [Ответ] -> Ваш номер телефона?".

1. Microsoft Phi-3 (1.3B - 3.8B параметров) — «Маленький гений»

Фишка: Самая умная в своем классе. Microsoft заявляет, что Phi-3-mini (3.8B) по качеству рассуждений близка к моделям в 10 раз больше.

Архитектура: Оптимизирована для рассуждений и следования инструкциям на маленьком размере.

Для чего идеальна:

Классификация и NER с элементами логики.

Простая генерация кода/SQL.

Ситуации, где нужен баланс между "умом" и скоростью.

Ограничения: Все еще очень маленькая, знания ограничены.

2. Google Gemma (2B, 7B параметров) — «Надежный работяга»

Фишка: От создателей Gemini. Отличное качество "из коробки", хорошая поддержка инструментов (tool calling).

Архитектура: Классический decoder-only Transformer, похожий на Llama, но от Google.

Для чего идеальна:

Общие задачи NLP (классификация, суммаризация, Q&A с контекстом).

Как база для fine-tuning под вашу узкую задачу.

Хорошо работает с инструментами (можно научить вызывать API).

Ограничения: Gemma 2B может быть слишком простой для сложной логики.

3. TinyLlama (1.1B параметров) — «Универсальный солдат на минималках»

Фишка: Открытая, простая, обученная на огромном датасете. Идеальна для экспериментов и образования.

Архитектура: Упрощенная Llama.

Для чего идеальна:

Прототипирование пайплайнов, когда не жалко.

Задачи, где важна максимальная скорость и минимальные ресурсы (CPU-инференс).

Базовый fine-tuning для понимания процесса.

Ограничения: Низкое качество out-of-the-box, требует дообучения для серьезных задач.

4. Специализированные русскоязычные маленькие модели

Пример: Дообученные на русских данных версии Llama 7B или Mistral 7B от русских команд.

Фишка: Готовое понимание русского языка, культурного контекста, падежей.

Для чего идеальна: Все перечисленные выше задачи, но для русского языка, без необходимости дообучать базовую модель на русском.

Где искать: Hugging Face Hub с тегами russian, ru.

5. Модели для кода (Code-specific)

DeepSeek-Coder (1.3B, 6.7B): Специализирована на генерации и понимании кода. Даже маленькая версия (1.3B) может писать простые функции.

Starcoder (3B, 7B): Аналогично, от ServiceNow.

Для чего идеальна: Генерация шаблонного кода, анализ логов, простой рефакторинг.