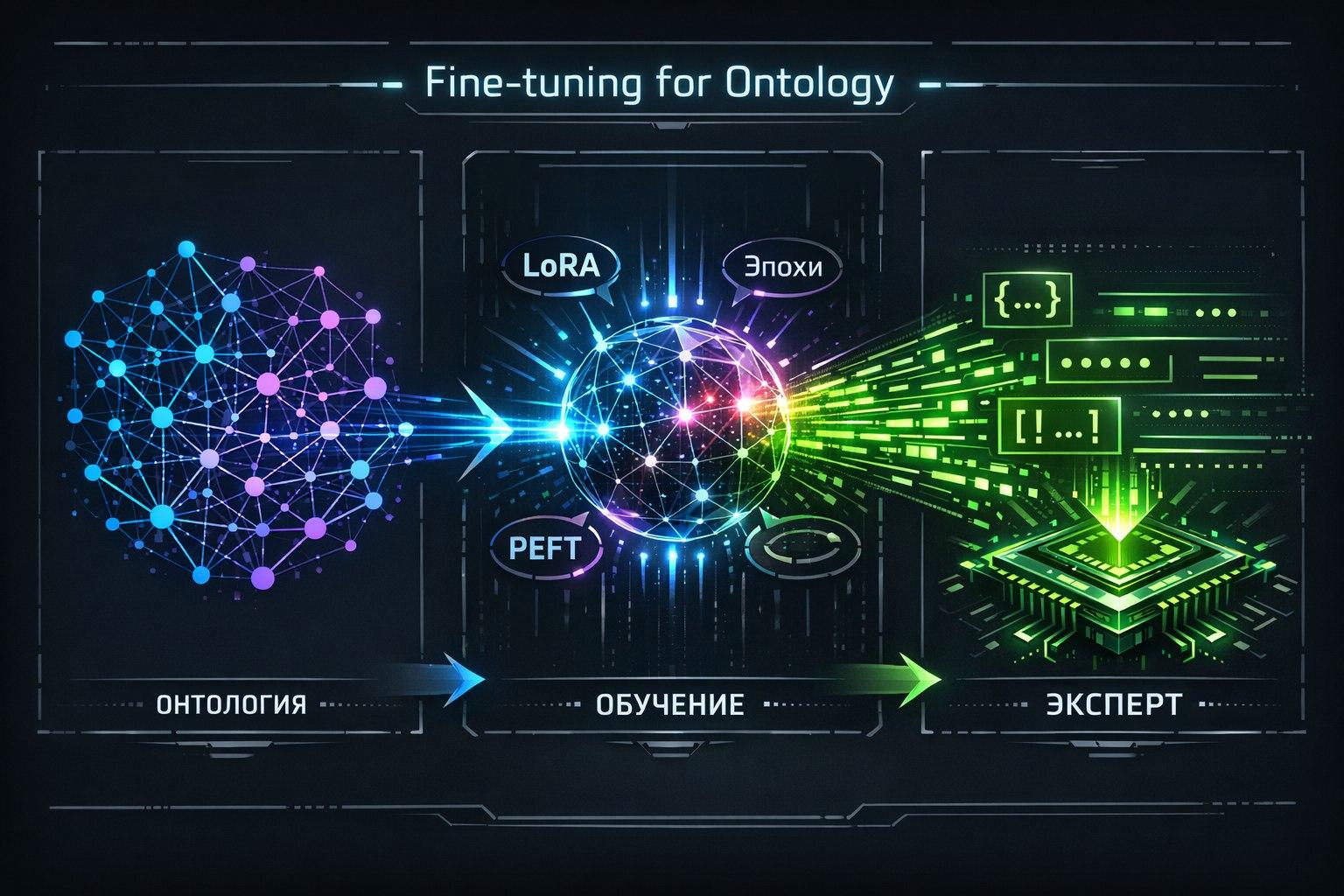

Вы разработали онтологию своей предметной области — формализованный граф знаний о сущностях, их свойствах и взаимосвязях. Следующий шаг — научить небольшую языковую модель «мыслить» в рамках этих категорий. Этот процесс превращает её из общего помощника в узкоспециализированного эксперта, чьи знания чётко определены и контролируемы.

Почему тандем «маленькая модель + онтология» идеален?

Специализация: Маленькая модель не распыляется на общие знания, а полностью фокусируется на вашей конкретной области.

Полный контроль: Вы определяете границы её компетенций через онтологию, исключая нежелательные отклонения.

Экономическая эффективность: Обучение и последующая работа возможны на центральном процессоре или недорогой видеокарте.

Предсказуемость: Модель демонстрирует детерминированное, ожидаемое поведение в рамках заданной схемы знаний.

Этап 1: Подготовка данных — «Перевод» онтологии на язык модели

Это самый важный этап. Необходимо превратить формальную онтологию (граф, OWL-файл) в текстовые примеры, на которых будет обучаться модель.

Метод 1: Синтетическая генерация вопросов и ответов (самый эффективный путь)

Создание шаблонов вопросов:

Для каждой сущности (класса) в онтологии: «Что такое [Договор]?», «Перечисли свойства [Сервера]», «Какие существуют виды [Отчётов]?».

Для каждой связи (отношения) между сущностями: «Как связаны [Клиент] и [Договор]?», «Что является результатом [Технического обслуживания]?».

Автоматическая генерация ответов: Используйте саму онтологию как источник истины. Ответы формируются автоматически на основе структуры онтологии, описывая свойства, связи и типы сущностей.

Инструменты для автоматизации: Используйте запросы к онтологической базе данных (например, SPARQL) для извлечения фактов и шаблонизаторы для создания разнообразных формулировок вопросов и ответов.

Метод 2: Создание диалоговых сценариев (для обучения поведению и логике)

Воссоздавайте реалистичные рабочие сценарии на основе онтологии, чтобы модель научилась не только фактам, но и их применению.

Пользователь: «Клиент А хочет расторгнуть договор №123.»

Идеальный ответ модели: «Для расторжения договора №123 необходимо: 1) Проверить его текущий статус (должен быть "Активен"), 2) Убедиться в отсутствии связанных невыполненных обязательств, 3) Инициировать процедуру уведомления, как описано в разделе 5.2 регламента.»

Метод 3: Контекстуальное обучение (прямое встраивание онтологии в инструкцию)

В системный промпт модели можно включить текстовое описание онтологии. Этот подход не требует тонкой настройки модели, но менее эффективен для глубокого усвоения сложных связей, так как полагается на контекстное окно модели.

Этап 2: Технические детали тонкой настройки (Fine-tuning)

Шаг 1: Выбор модели-основы

Для общих текстовых задач: Phi-3-mini (3.8B), Gemma (2B/7B).

Для задач, требующих чёткого следования инструкциям и структурированного вывода: Phi-3 часто показывает лучшие результаты.

Шаг 2: Подготовка датасета

Данные должны быть представлены в формате «инструкция — ответ». Каждый пример включает в себя задачу (instruction), контекст (input, если есть) и эталонный ответ (output), сформированный на основе онтологии.

Шаг 3: Применение PEFT (эффективной настройки параметров)

Для маленьких моделей обязательным стандартом стали методы LoRA или QLoRA. Они позволяют дообучить не все миллиарды параметров модели, а лишь небольшие, адаптивные слои, встроенные в неё. Это делает обучение быстрым (часы, а не дни), дешёвым (требуется одна видеокарта) и предотвращает «катастрофическое забывание» исходных знаний модели.

Ключевые настройки для онтологического обучения:

Низкая скорость обучения: Позволяет знаниям аккуратно «встраиваться» в модель.

Большее количество эпох: 3-5 проходов по данным вместо 1-2 для лучшего закрепления информации.

Структура данных: Включение системного промпта (роли эксперта) в каждый пример обучения.

Этап 3: Обучение структурированному выводу

Цель — научить модель не только рассуждать в рамках онтологии, но и выдавать результат в строгом, машиночитаемом формате.

Формулировка задач: Создавайте инструкции, требующие вывода в определённой форме: «Ответ дай в формате: {"ответ": true/false, "обоснование": "..."}».

Генерация структурных форматов: Обучайте модель представлять информацию в виде JSON-LD или аналогичных форматов, напрямую соответствующих классам и свойствам онтологии.

Этап 4: Валидация и оценка

Проверка качества — критически важный шаг. Используйте несколько типов метрик:

Фактологическая точность: Процент правильных ответов на прямые вопросы по онтологии.

Логическая непротиворечивость: Серии связанных вопросов, ответы на которые должны быть согласованными.

Следование ограничениям: Способность модели распознавать и отвергать запросы, противоречащие правилам онтологии (например, приписывание сущности свойства, которое для неё не определено).

Качество структурированного вывода: Процент валидных JSON-ответов и полнота заполнения обязательных полей.

Практический кейс: Создание IT-инфраструктурного эксперта на модели 3B параметров

Онтология: Сервер → запускает → Сервис → использует → База данных.

Процесс:

Датасет: 500+ примеров Q&A, 200+ диалоговых сценариев (например, диагностика инцидентов), 100+ задач на логический вывод (например, «какие сервисы затронет отключение этого сервера?»).

Обучение: Дообучение модели Phi-3-mini с использованием LoRA.

Результат: Модель, которая точно отвечает на фактологические вопросы, предлагает осмысленные процедуры диагностики на основе связей в онтологии, генерирует структурированные отчёты и работает с задержкой менее 300 мс на CPU.

Расширенные техники

Обучение работе с графом: Включение в обучение задач, где модель должна мысленно выполнять запросы к графу знаний (например, «найди все сервисы, зависящие от этой базы данных»).

Многошаговые рассуждения: Обучение на сложных сценариях, требующих построения логических цепочек через несколько сущностей и отношений онтологии.

Типичные проблемы и их решения

Проблема: Модель «галлюцинирует», выдумывая сущности или факты, которых нет в онтологии.

Решение: Увеличить количество и качество обучающих примеров для слабых мест; использовать техники, ограничивающие генерацию только разрешёнными терминами на этапе выдачи ответа.

Проблема: Модель путает сложные отношения (наследование, состав).

Решение: Специально увеличить представительство примеров, иллюстрирующих эти сложные связи в датасете.

Вывод

Обучение маленькой модели онтологии — это создание высокофокусированного цифрового эксперта. Ключевой фактор успеха — не объём, а качество и структурная целостность обучающих данных, которые должны исчерпывающе отражать онтологию. Инвестировав время в создание идеального датасета, вы получаете модель на 3-7 миллиардов параметров, которая становится быстрым, контролируемым и экономичным специалистом, работающим внутри вашей инфраструктуры и идеально понимающим ваш предметный язык.