Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

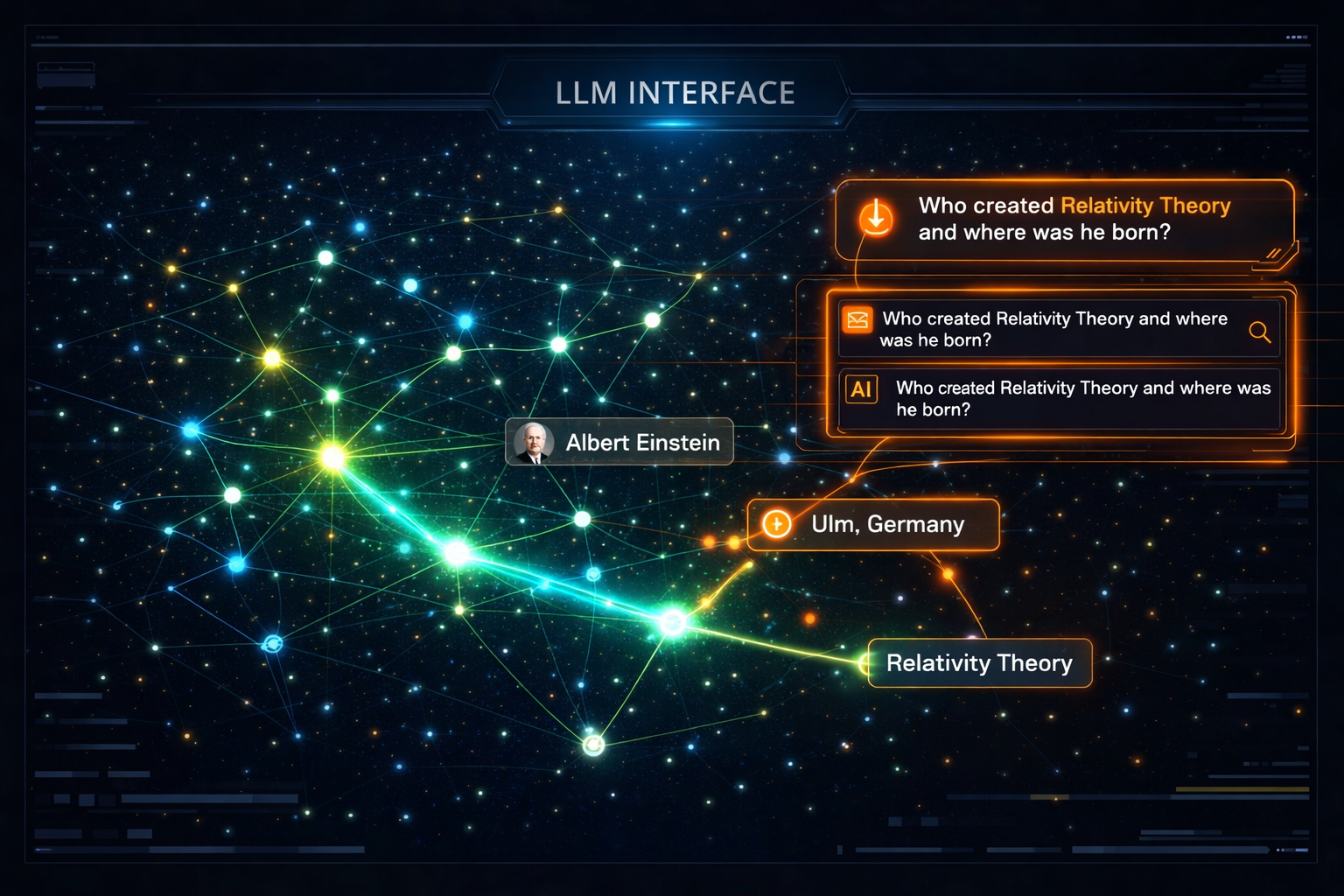

От текстового паттерн-матчинга к семантическому пониманию предметной области. Практическое руководство по созданию и использованию онтологий для обучения LLM.

Когда ваша LLM отвечает на вопрос в области медицины или юриспруденции, она оперирует статистическими связями между словами. Эксперт же оперирует понятиями и их отношениями: «диагноз» является показанием для «процедуры», которая имеет побочный эффект «симптом». Чтобы AI мыслила как эксперт, ей нужна онтология — формальная модель знаний о предметной области.

Почему промптов и RAG недостаточно?

Поверхностное понимание: Модель может найти в документах термины «гипертензия» и «лозартан», но не поймет, что это болезнь и лекарство от этой болезни , если это прямо не написано.

Хрупкость: Ответ зависит от удачной формулировки в промпте. Онтология дает структуру, которая делает рассуждения модели более устойчивыми.

Невозможность сложных выводов: Без онтологии модель не сможет ответить на вопрос: «Какие препараты, аналогичные лозартану, не вызывают кашель?». Для этого нужно знать: классы препаратов, отношения «аналог», побочные эффекты.

Что такое онтология в контексте AI?

Это не просто глоссарий, а граф знаний (Knowledge Graph), где:

Сущности (Entities/Concepts): Понятия предметной области (например, Patient, Diagnosis, Medication, ClinicalTrial).

Отношения (Relations/Properties): Связи между сущностями ( hasDiagnosis, treatedWith, hasSideEffect, contraindicatedFor).

Атрибуты (Attributes): Свойства сущностей ( dosage, onsetDate, severityScore).

Аксиомы и правила (Axioms & Rules): Логические утверждения. Например: IF (Drug A isContraindicatedFor Disease B) AND (Patient has Disease B) THEN NOT prescribe Drug A.

Этап 1: Разработка онтологии (Domain Modeling)

Это задача для экспертов предметной области (SME) и онтологов/дата-инженеров.

Выявление ключевых понятий: Интервью с экспертами, анализ документации. Какие сущности они постоянно упоминают?

Определение отношений: Как эти сущности связаны? Составьте пары: «Может ли [Сущность А] быть связана с [Сущностью Б]? Если да, как?».

Выбор формата и инструмента:

OWL/RDF (стандарт де-факто): Мощно, формально, совместимо с семантическим вебом. Инструменты: Protégé, TopBraid.

Property Graph (Neo4j): Более интуитивно для разработчиков, акцент на обходе графов.

Упрощенный JSON-LD/YAML: Для начала, если область не слишком сложная.

Популяция онтологии (наполнение экземплярами): Medication:Лозартан — это экземпляр класса AntihypertensiveDrug.

Этап 2: Интеграция онтологии в обучение LLM

Существует не один, а целый спектр методов, от простых к сложным.

Метод 1: Контекстуализация через промпты (Самый быстрый)

Как: В системный промпт включается текстовое описание онтологии: «Ты — медицинский ассистент. Ты знаешь, что существуют Лекарства, Болезни и Симптомы. Лекарства лечат Болезни. Болезни вызывают Симптомы...».

Плюсы: Мгновенно, не требует переобучения.

Минусы: Ограниченное влияние, модель может игнорировать.

Практика: Используйте формат, который LLM понимает лучше всего — списки и четкие инструкции.

Метод 2: Создание синтетических данных на основе онтологии (Крайне эффективный)

Это ключевая техника для качественного обучения.

Процесс: Используя онтологию, вы генерируете тысячи пар «вопрос-ответ» или «инструкция-результат», которые отражают отношения в графе .

Шаблон 1 (Фактологический): Вопрос: «Какие лекарства лечат гипертензию?» Эталонный ответ (из онтологии): «Лозартан, Эналаприл (являются экземплярами класса AntihypertensiveDrug и связаны отношением treats с Hypertension).»

Шаблон 2 (Логический вывод): Контекст: «У пациента гипертензия. Лозартан вызывает кашель как побочный эффект.» Вопрос: «Можно ли назначить лозартан пациенту с кашлем?» Ответ: «Нет, потому что лозартан вызывает кашель, что может ухудшить состояние.»

Инструменты: Можно использовать саму LLM (например, GPT-4) для генерации вариаций вопросов по схеме, но валидация экспертом обязательна.

Метод 3: Fine-tuning на синтетических данных + онтологические эмбеддинги

Шаг А: Делаете fine-tuning модели на сгенерированном датасете (Метод 2). Это учит модель языку и шаблонам рассуждений предметной области.

Шаг Б (Продвинутый): Совместное обучение текстовым и графовым эмбеддингам. Вы представляете онтологию как граф, обучаете эмбеддинги для сущностей и отношений (например, с помощью TransE, ComplEx). Затем либо:

Конкатенируете текстовый эмбеддинг (от BERT) и графовый эмбеддинг сущности, чтобы получить общее представление.

Учите модель работать с этим гибридным представлением во время fine-tuning, явно указывая в данных тип сущности и ее связи.

Метод 4: Архитектуры, основанные на графах знаний (KG-Augmented LLMs)

Это передний край исследований, например, K-BERT или приемы Graph Neural Networks (GNN) + LLM.

Идея: Архитектура модели явно включает модуль для обработки графа знаний. На этапе инференса модель не только читает текст, но и «запрашивает» связанные сущности из онтологии, чтобы обогатить контекст.

Реализация сейчас: Чаще всего это выглядит как гибридная система: RAG, где вместо векторного поиска по документам выполняется семантический запрос к графу знаний (например, на языке SPARQL), а результаты запроса подаются в LLM как контекст.

Этап 3: Валидация и оценка

Как понять, что модель действительно усвоила онтологию, а не выучила шаблоны?

Закрытый тест (Hold-out) на синтетических данных: Проверка на вопросах, которых не было в обучении, но ответы на которые есть в онтологии.

Тесты на логическую непротиворечивость: Задавайте каверзные вопросы. «Если А является подклассом Б, а Б является подклассом В, то А является подклассом В?»

Оценка экспертами: Эксперты задают живые, сложные вопросы и оценивают не только фактологическую точность, но и качество рассуждений.

Практический кейс: Онтология для IT-инфраструктуры

Сущности: Server, Service, Incident, Log, Metric.

Отношения: Server hosts Service, Service generates Log, Incident affects Service, Metric monitors Server.

Применение: Обученный с такой онтологией AI-агент сможет отвечать: «Какие сервисы упадут, если мы выведем на обслуживание сервер X?» (логический вывод через граф: Server X -> hosts -> [Services]).

Вывод для Chief AI Officer:

Обучение модели с онтологией — это переход от создания «эрудированного стажера» к созданию «рассуждающего эксперта». Это требует серьезных инвестиций в инженерию знаний (knowledge engineering), но окупается беспрецедентной точностью, объяснимостью и надежностью AI в сложных предметных областях. Начните с малого: создайте ядро онтологии, сгенерируйте синтетические данные и примените fine-tuning. Это уже даст качественный скачок по сравнению с обычным RAG.