Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

Контроль, стоимость, безопасность данных. Когда свой Llama лучше, чем облачный GPT.

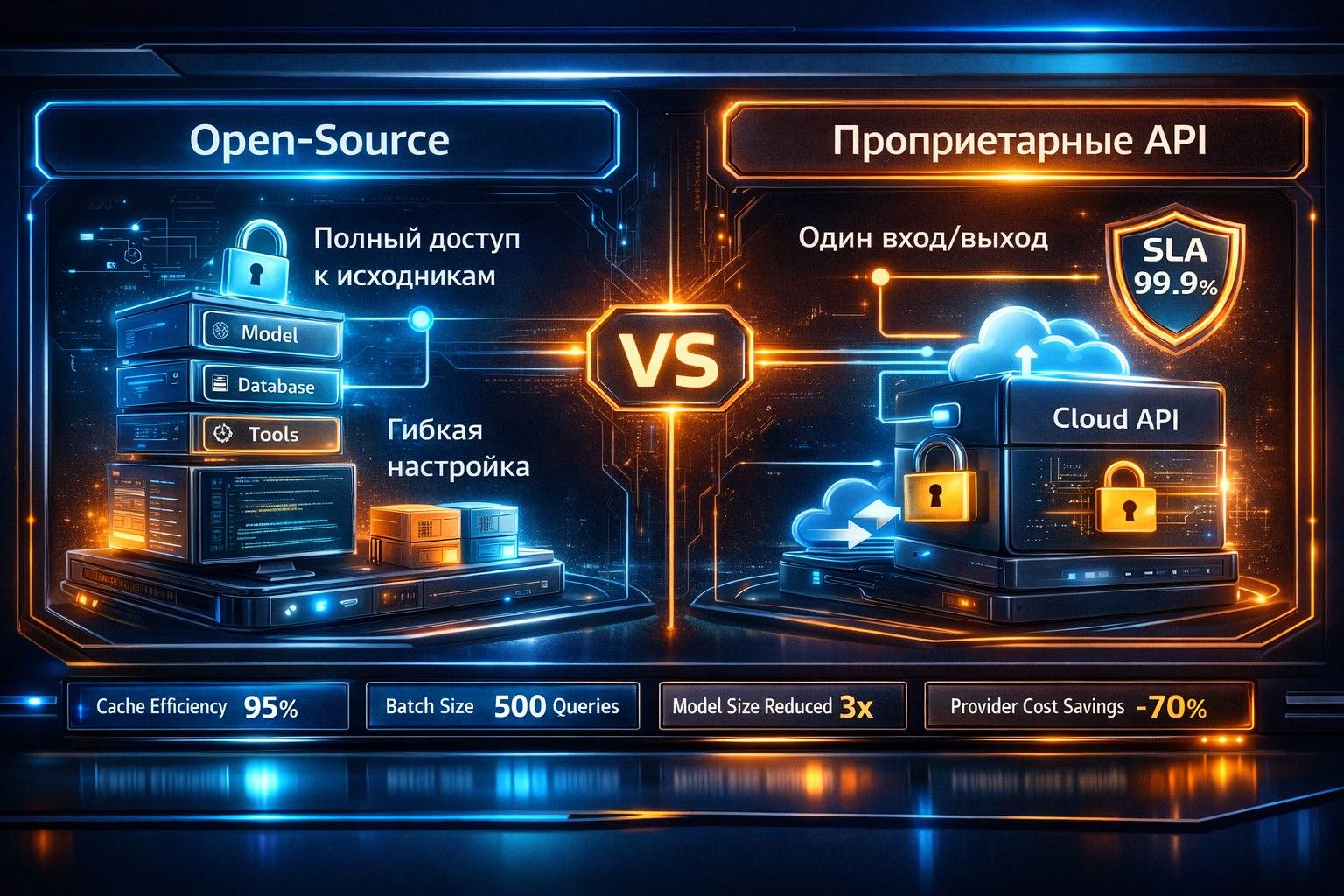

Перед каждым техлидом, начинающим AI-проект, встает фундаментальный вопрос: использовать облачные API (OpenAI GPT, Anthropic Claude, Google Gemini) или развернуть open-source модель (Llama, Mistral, Qwen) у себя? Это не технический каприз, а стратегический выбор, определяющий бюджет, безопасность и гибкость вашего решения.

Проприетарные API (GPT, Claude): Быстрый старт с ограничениями

Плюсы:

State-of-the-Art качество: Лидеры по способностям к рассуждению и креативу.

Нулевые операционные расходы (OpEx): Не нужно покупать GPU, настраивать кластеры. Платишь только за токены.

Простота масштабирования: Провайдер берет на себя всю инфраструктуру, доступность 99.9%.

Постоянные обновления: Вы всегда получаете доступ к самой свежей и улучшенной версии модели.

Минусы (критичные для enterprise):

Выходные данные — ваши, входные — их? Политика использования данных. Ваши промпты и данные могут использоваться для улучшения моделей (если явно не отключено, как в Azure OpenAI). Юридически неприемлемо для медицины, финансов, госсектора.

«Черный ящик»: Вы не контролируете, что происходит внутри модели. Сложно гарантировать полное отсутствие backdoor или соблюдение специфичных требований.

Зависимость от API: Рост цен, изменение правил, простои у провайдера — ваши риски.

Латентность: Запрос всегда уходит во внешнюю сеть.

Open-Source LLM (Llama, Mistral): Полный контроль с головной болью

Плюсы:

Полный суверенитет данных: Модель работает внутри вашего периметра. Данные никуда не уходят. Это главный аргумент.

Прозрачность и возможность аудита: Можете исследовать архитектуру, дообучать под любые, даже самые экзотические нужды.

Предсказуемая стоимость (CapEx): Разовые затраты на железо или аренду GPU. При высоких объемах трафика — дешевле в долгосрочной перспективе.

Независимость: Нет рисков, связанных с внешним провайдером.

Минусы:

Высокий порог входа: Требуются экспертиза в ML Ops, инфраструктура (GPU-серверы, orchestration), команда для поддержки.

Качество может отставать: Хотя лидеры OSS (Llama 3, Mixtral) догоняют GPT-4 по многим задачам, в сложных рассуждениях разрыв еще есть.

Операционные расходы на инфраструктуру: Покупка/аренда GPU, электричество, охлаждение, администрирование.

Ответственность за обновления и безопасность модели лежит на вас.

Гибридная стратегия — путь прагматика

Прототипирование и MVP: Используйте проприетарные API. Быстро, дешево, чтобы доказать ценность и набрать данные.

Пилот для некритичных задач: Для внутренних задач (суммаризация встреч, генерация идей) можно остаться на API.

Промышленное внедрение с sensitive-данными: Для работы с персональными данными клиентов, финансовой отчетностью, медицинскими записями — развертывайте OSS-модель в своем контуре.

Смешанная архитектура (Hybrid Cloud): Используйте легкую локальную OSS-модель для обработки входящих запросов и фильтрации. Сложные запросы, не содержащие конфиденциальных данных, отправляйте в мощный облачный API.

Технический чек-лист для выбора OSS:

Размер модели: 7B параметров (для чата на CPU/слабом GPU), 70B (для сложных задач, требует мощных GPU).

Формат и фреймворк: Поддержка GGUF (для эффективного запуска на CPU через llama.cpp), PyTorch, Hugging Face Transformers.

Инструменты для инференса: vLLM (для максимальной скорости на GPU), Ollama (для простого локального развертывания), TensorRT-LLM (оптимизация от NVIDIA).

Вывод для CISO и CTO:

Выбор между облаком и локальным развертыванием — это баланс между скоростью/качеством и контролем/безопасностью. Нет универсального ответа. Но есть правило: если ваши данные регулируются GDPR, ФЗ-152, HIPAA или являются коммерческой тайной — стратегия должна склоняться в сторону open-source решений внутри защищенного контура. Инвестируйте в экспертизу MLOps, она окупится независимостью и безопасностью.