Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

Открыты для сотрудничества с яркими инициативными командами.

info@interactrivemedia.dev

t.me/InteractiveMedia_dev

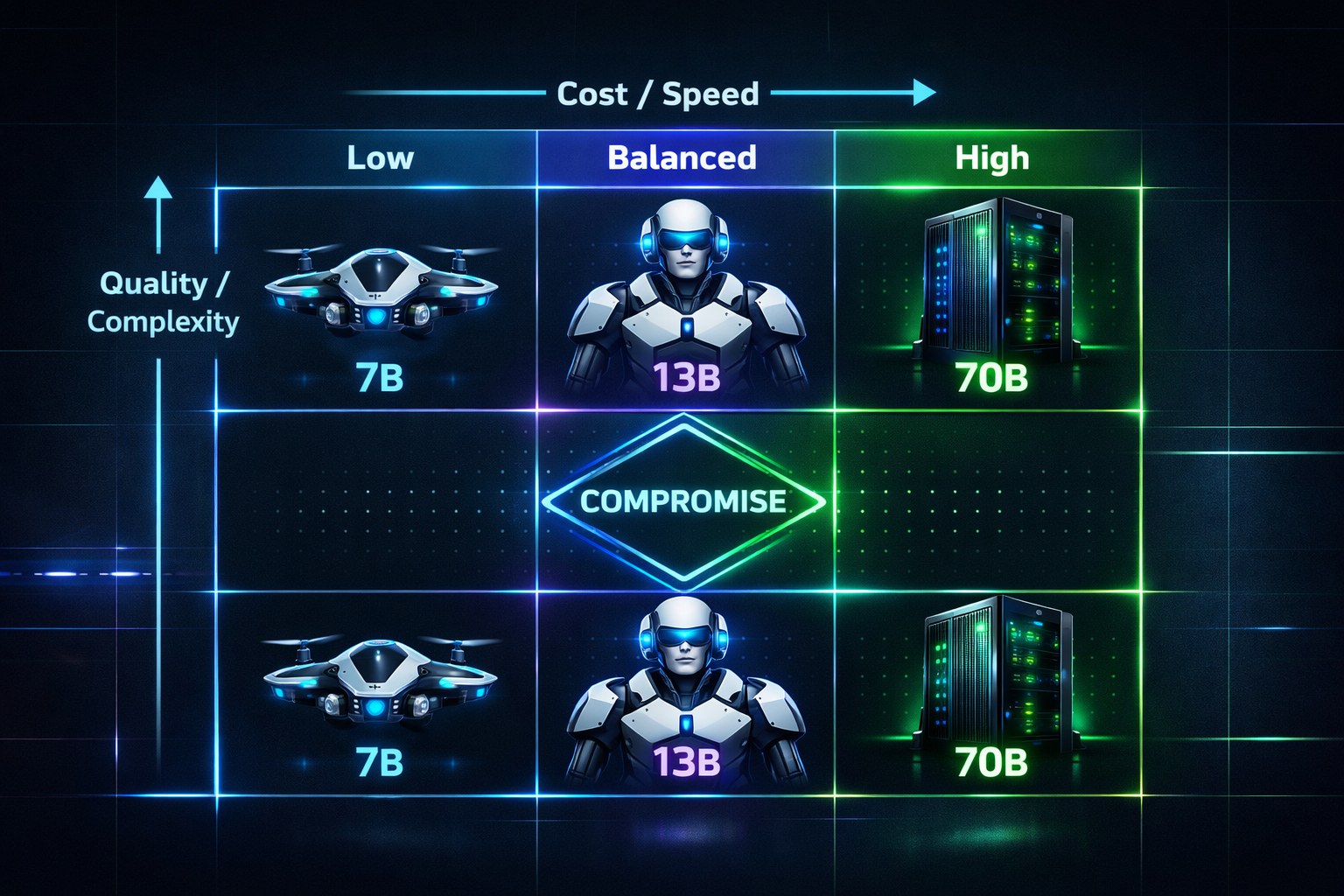

Почему больше — не всегда лучше. Как оценить необходимую «интеллектуальную мощь» модели под ваши задачи и инфраструктуру.

Вы открываете каталог моделей и видите: 7B, 13B, 34B, 70B, 180B, 400B+ параметров. Интуиция подсказывает: «Бери самую большую, она умнее». Но реальность жестока: модель на 70B параметров может быть в 10 раз дороже в обслуживании и в 5 раз медленнее, чем модель на 7B, прирост качества для вашей задачи при этом составит лишь 5-15%. Выбор размера — это поиск оптимальной точки на кривой «качество-стоимость-скорость».

Ключевые факторы выбора

1. Характер задачи (Task Complexity)

Это главный фактор. Разделим задачи на уровни:

Уровень 1: Классификация, извлечение сущностей, перефразирование, простой Q&A по контексту.

Пример: Определить тональность отзыва, извлечь дату и сумму из письма, переписать заголовок, ответить на вопрос по ясно изложенной инструкции.

Рекомендуемый размер: 1B - 7B параметров. Небольшие модели ( Llama 3 8B, Mistral 7B, Gemma 7B) справляются отлично, часто даже лучше больших, потому что меньше «отвлекаются» и более предсказуемы.

Уровень 2: Сложный Q&A с поиском по базе (RAG), суммаризация, средняя креативность, простой анализ.

Пример: Ответить на составной вопрос, используя несколько документов RAG. Суммаризировать диалог поддержки. Придумать варианты слогана. Проанализировать плюсы/минусы предложения.

Рекомендуемый размер: 7B - 13B параметров. Золотая середина. Модели этого уровня ( Llama 3.1 8B, Mixtral 8x7B (фактически ~45B, но эффективно), Qwen 14B) имеют достаточно «рассудительности» для работы с контекстом и выводами.

Уровень 3: Сложные рассуждения, планирование, генерация кода, углубленный анализ, творчество.

Пример: Написать рабочую функцию на Python по описанию. Разработать план проекта. Найти логическую ошибку в тексте. Написать сложный маркетинговый текст в определенном стиле.

Рекомендуемый размер: 34B - 70B параметров. Здесь нужна «глубина». Модели ( Llama 3 70B, Qwen 32B, Mixtral 8x22B) демонстрируют резкий скачок в способности к рассуждению (reasoning) и следованию сложным инструкциям (instruction following).

Уровень 4: Исследовательские задачи, научный анализ, сверхсложная креативность, бенчмаркирование.

Пример: Генерация новых исследовательских идей, написание научных обзоров, создание сложных артефактов (длинные сценарии, стратегии).

Рекомендуемый размер: 70B+ параметров или специализированные большие модели ( GPT-4, Claude 3 Opus, DeepSeek-V2). Это выбор, когда цена вопроса — максимальное качество, а не стоимость.

2. Инфраструктура и бюджет (Инференс и обучение)

Это ограничивающий фактор. Задайте себе вопросы:

Инференс (вывод):

Серверное/Облачное развертывание:

7B-13B: Работают на одной мощной GPU (A100 40GB, H100, RTX 4090) или даже на CPU с оптимизацией (GGUF + llama.cpp).

34B-70B: Требуют 2-4 топовых GPU с tensor parallelism для приемлемой скорости. На CPU — очень медленно.

70B+: Кластер из 4-8+ GPU. Серьезная инженерная задача.

Крайний случай — Edge-устройства (телефоны, IoT): Только крошечные модели (<3B) или специализированные (<1B): Phi-3-mini, Gemma 2B, Qwen2.5-Coder 1.5B.

Обучение (Fine-Tuning):

Full Fine-Tuning 7B модели требует ~4x памяти от размера модели (около 30GB GPU RAM).

Используйте PEFT (LoRA, QLoRA): Это меняет правила игры. QLoRA позволяет дообучить модель 7B на одной 24GB GPU (RTX 4090), а модель 70B — на одной 48GB GPU (A6000). Для большинства практических задач сегодня стартовать следует именно с PEFT.

3. Критичность задержки (Latency) и пропускная способность (Throughput)

Диалоговый интерфейс (чат): Приемлемая задержка <2-3 секунды. Для 7B-13B моделей на хорошем железе это достижимо.

Пакетная обработка (ночная суммаризация логов): Задержка не важна, важна пропускная способность и стоимость. Можно использовать меньшие модели и обрабатывать много запросов параллельно.

Высокочастотный API (тысячи запросов в секунду): Скорее всего, потребуются маленькие модели (1B-7B) и серьезное масштабирование (много реплик).

Практическое правило: «Начни с малого, масштабируй по необходимости»

Прототипируйте на самой маленькой подходящей модели (7B-13B). Настройте на ней пайплайн (RAG, промпты).

Создайте бенчмарк ваших задач. Измерьте качество (accuracy, F1, человеческая оценка), скорость и стоимость.

Поднимите размер модели (например, до 34B-70B). Замерьте те же метрики.

Примите решение: Дает ли удорожание в 5-10 раз прирост качества, оправдывающий это для бизнеса? Часто оказывается, что для 80% задач достаточно 7B-13B модели, а оставшиеся 20% сложнейших запросов можно маршрутизировать на большую модель (техника model routing).

Таблица-шпаргалка:

| Размер | Примеры моделей | Задачи | Инференс (мин. GPU) | Fine-Tuning (с QLoRA) | Когда выбирать |

|---|---|---|---|---|---|

| <3B | Phi-3-mini, Gemma 2B | Классификация, NER, простейший чат | CPU / мобильная GPU | Легко на любой GPU | Edge, мобильные приложения, тривиальные задачи. |

| 7B-13B | Llama 3.1 8B, Mistral 7B, Qwen2.5 14B | RAG, суммаризация, чат-боты, базовый анализ. | 1x RTX 4090 / A10 | Легко на 1x 24GB GPU | Старт 90% проектов. Баланс цены и качества. |

| 34B-70B | Llama 3 70B, Qwen 32B | Сложный анализ, генерация кода, планирование. | 2-4x A100/H100 | Возможно на 1-2x A100 (48GB) с QLoRA | Критически важное качество рассуждений. Есть бюджет на инфраструктуру. |

| >70B / Массивные | GPT-4, Claude Opus, смеси экспертов (MoE) | Исследования, максимальное качество, бенчмарки. | Кластер GPU / Облачный API | Практически невозможно самостоятельно | Максимальный quality ceiling. Готовность платить премиум. |

Вывод для технического лида:

Размер модели — не трофей, а инструмент с ценой. Самый разумный путь — начать с архитектуры, построенной вокруг модели 7B-13B, и использовать RAG и промпт-инжиниринг для компенсации ее «неглубоких» знаний. Масштабируйте размер модели вверх только тогда, когда упретесь в потолок качества, который нельзя преодолеть архитектурно, и когда бизнес-ценность этого скачка перевешивает затраты. Часто лучше потратить сэкономленные ресурсы на улучшение данных (RAG, онтологию) и пайплайнов, чем на аренду гигантского GPU-кластера.